Cher lecteur 👋

Ça fait longtemps que je n’avais pas écrit et pour cause : je lançais un nouveau projet, Argil.ai, dont l’objectif est de permettre à n’importe qui d’intégrer l’IA (d’abord l’image, ensuite le texte) à son quotidien grâce à une plateforme no-code modulable.

Si tu es designer, marketer, product designer ou entrepreneur, je serais ravi d’en discuter avec toi. N’hésite pas à me prendre un créneau, à t’inscrire à la beta ou à répondre à cet email.

Par ailleurs, la plupart de ma communication se fait dorénavant sur twitter (en Anglais). N’hésite pas à me suivre si les sujets IA t’intéressent.

Les 5 révolutions de l’IA

Cet épisode est disponible en podcast (8 minutes d’écoute) 🔉 ! Tu peux aussi l’écouter sur Spotify, Apple podcasts, Deezer, et lien RSS direct.

Note : le gros de cet article a été rédigé il y a une dizaine de jours, avant des annonces majeures comme Adobe firefly, GPT plugins, ainsi que l’email de Bill Gates qui présente l’IA comme l’un des 2 évènements clés de sa vie - au même niveau que l’invention de l’ordinateur. Ces dernières sorties vont non seulement dans le sens du contenu ci-dessous mais ont augmenté d’un degré ma conviction sur l’aspect transformateur de cette technologie. Bonne lecture 😉

Ces derniers mois ont été un tremblement de terre dans le monde de la tech. L’émergence des IAs d’image et surtout l’arrivée de chatGPT ont pris de court toutes les industries, notamment l’écosystème des startups où chacun essaie d’intégrer tant bien que mal un morceau de la technologie à son produit pour rester dans la course.

Deux écoles s’affrontent sur l’aspect révolutionnaire - ou pas - des intelligences artificielles génératives.

La première, majoritairement constituée de chercheurs (dont le très connu Yann LeCun, patron de la branche IA de Méta), défend que chatGPT n’a rien d’incroyable : ça fait des années que les équipes de recherche arrivent à des résultats proches et chatGPT est une sorte de “perroquet idiot” qui régurgite de l’information sans la comprendre - et qui sort parfois des aberrations avec un aplomb extraordinaire.

La seconde, principalement incarnée par des entrepreneurs, se concentre sur l’usage : d’après eux, chaque technologie a un point de bascule à partir de laquelle elle peut trouver son sens dans le quotidien des gens. Et une fois qu’on a franchi ce point de bascule, une nouvelle industrie colossale peut voir le jour, qui changera définitivement notre rapport à la technologie.

Les chiffres me font pencher très fortement dans la deuxième catégorie, pour une raison très simple : aucune technologie de mémoire récente n’a été si rapidement testée et adoptée par des personnes non-techniques.

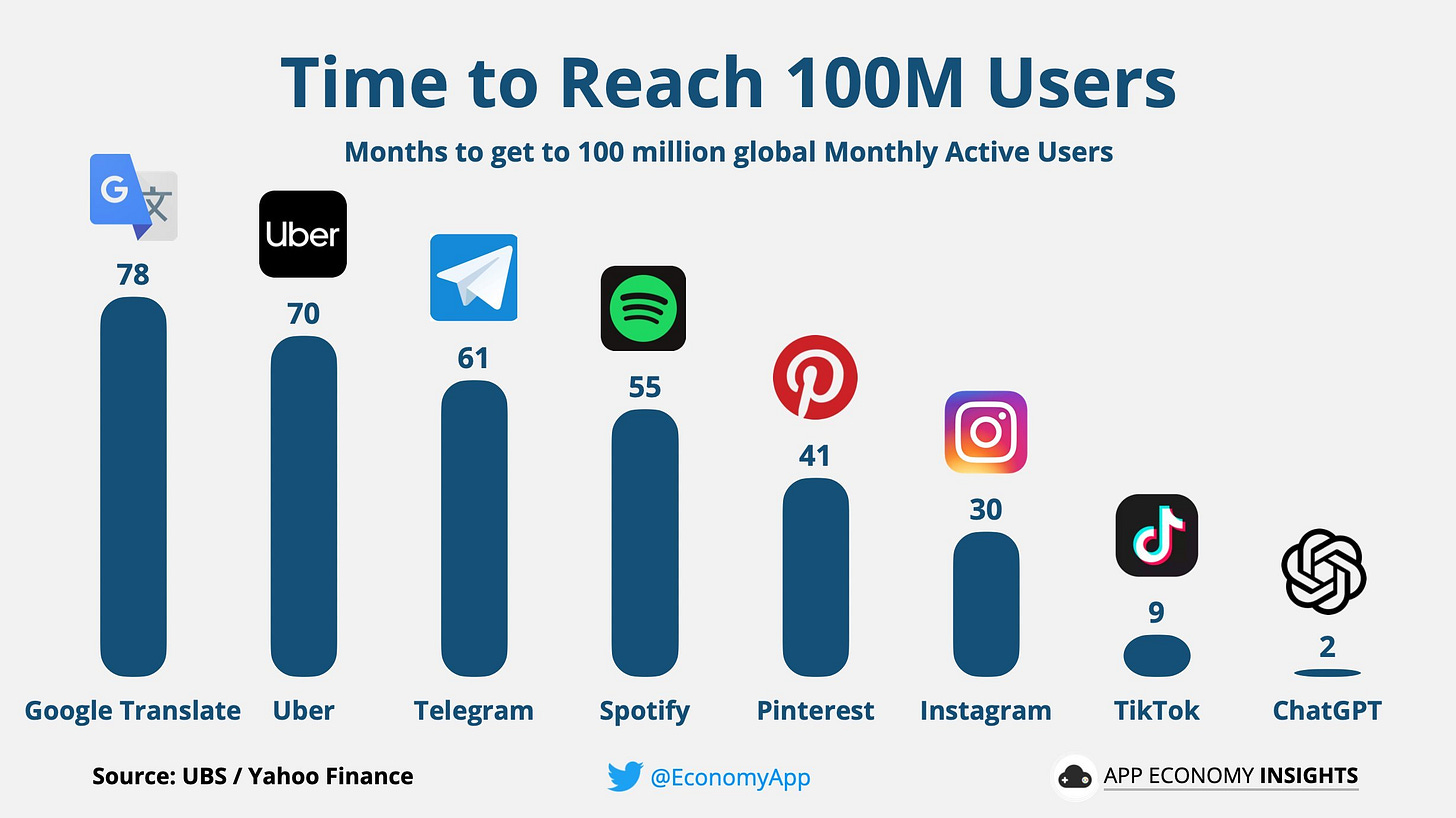

ChatGPT a été le produit le plus rapide de l’histoire à franchir 100 millions d’utilisateurs - avec une large avance.

Même si ce graphique est à pondérer, notamment car jamais une portion aussi importante de l’humanité n’a eu accès à internet, les ordres de grandeur parlent d’eux-mêmes.

Durant ces deux derniers mois que j’ai passé au plus près de l’IA et avec beaucoup de recul depuis mon dernier article “AI is eating the world”, j’ai formé 5 certitudes :

Les artistes devront l’adopter

Nous allons migrer de la création à l’édition

L’IA est le vrai “Web 3”

La technologie va détruire des jobs

C’est une aubaine pour les métavers (et les scénarios dystopiques)

Les artistes devront l’adopter

Notre cerveau est une machine à transformer et régurgiter de l’information. En écrivant cet article, je n’invente absolument rien - je transforme de l’expérience et de la recherche en un fil de pensée structuré.

Il en va de même pour l’art - je ne crois pas que l’on produise quelque chose ex-nihilo. Toute inspiration vient de quelque part, fut-ce de notre observation de la nature. L’IA adopte finalement un mécanisme assez proche.

Néanmoins, je ne suis pas insensible à la cause des artistes et je comprends leur rejet violent. Ayant moi-même écrit un roman, je suis contraint de me demander combien de temps va s’écouler avant qu’un algorithme soit en capacité de produire un résultat de la même qualité.

Est-ce une bonne chose ? Je l’ignore (probablement pas) et mon avis importe peu, car une chose est sûre : jamais la nature humaine n’a pu s’affranchir d’une technologie de cette amplitude. La curiosité est ancrée en nous.

Tenter d’interdire cette technologie est vain sur le long terme - l’enjeu est de la mener où l’on souhaite et d’en tirer le meilleur. Demain, le travail d’artiste pourrait être de pousser à son paroxysme les capacités de l’IA pour créer des histoires toujours plus touchantes.

Et à très long terme, qui sait ce que sera devenue la nature humaine ou notre vision du progrès ? Nous sommes programmés pour aller de l’avant, mais on ne peut parfois s’empêcher de se demander à quel stade le progrès pourrait être néfaste.

Car l’IA ne va pas seulement changer le domaine de l’art.

L’édition va remplacer la création

Je considère qu’il y a deux types d’écriture : l’écriture à but éducatif et l’écriture à but narratif. La première nécessite de la clarté et le travail d’écriture est peu valorisant, la seconde nécessite un travail d’imagination et de style qui fait de l’écriture un loisir.

La plupart des technologies dans l’histoire ont rendu l’édition plus simple. Écrire et se corriger sur un clavier est plus simple et rapide qu’avec une machine à écrire, qui était déjà plus simple qu’avec un stylo à encre.

Or, l’IA s’apprête à rendre la création massivement plus rapide, ce qui va entièrement modifier la manière dont nous écrivons du contenu long.

Rédiger un mémoire de thèse, par exemple, c’est mettre à plat de manière structurée des années de recherche et d’efforts, de notes et de références.

Demain, il y a fort à penser que l’IA génèrera très facilement des documents, emails, comptes-rendus et mémoires à base de notes - tout ce qui ne nécessite pas d’effort stylistique ou qui peut être déterminé à partir de ce qu’on a déjà rédigé.

De la même manière, l’IA pourra générer des images avec des inspirations diverses et produire un canvas qui sera modifiable par un designer.

Aussi, je prédis que dans quelques années, voire quelques mois, la plupart du contenu qui sera généré en ligne, quel que soit son but, sera issu de l’édition par son auteur d’une création algorithmique.

Cela signifie que le contenu créé risque de s’uniformiser à grande vitesse, comme le physique des influenceurs et influenceuses instagram, de plus en plus standardisé grâce aux filtres qui poussent à ressembler à une “moyenne” de physiques qui plaisent.

Tout en sacrifiant une part de notre authenticité, cela représentera un gain de temps massif qui pourra être déporté sur autre chose - comme une conversation avec notre navigateur, par exemple. Car l’IA implique une nouvelle version du web.

L’IA est le vrai “Web3”

Autrement dit, nous allons passer de l’internet statique à l’internet conversationnel.

Posons le décor : le terme de “Web 3” s’est démocratisé par les partisans de la blockchain il y a quelques années pour succéder à ses deux premières itérations, le Web 1 et le Web 2. En voici une brève définition :

Le Web1 (1991) : des pages internet basiques et statiques où l’utilisateur est un pur consommateur d’informations

Le Web2 (début 2000) : l’utilisateur n’est plus seulement spectateur, il devient participant, notamment avec la création de contenus (forums) et l’arrivée de types de contenus plus riches (vidéo, etc.)

Le Web3 (2020’s): l’internet décentralisé où chaque utilisateur devient partie prenante via la blockchain et des tokens reprenant aux big tech le monopole centralisé de la data et du contenu.

En théorie, cela paraît viable et la blockchain est pleine de promesses. Mais il manque d’après-moi un élément clé pour se voir attribuer ce titre : l’usage.

Une nouvelle version d’internet, avec sa propre définition, doit être universelle et adoptée par la plupart des internautes. Or, le papier originel de la blockchain a une quinzaine d’années et la technologie peine toujours à démontrer des usages forts.

Penses-tu que ton fleuriste utilise le wallet crypto metamask ? Le retraité du village ? Ton garagiste ? Probablement pas. Et si c’est le cas, il est plus probable que ce soit par appât du gain plutôt que par idéologie.

En revanche, presque tous ces gens ont essayé chatGPT quelques semaines après son arrivée. Une bonne partie de mon entourage se sert déjà de l’IA tous les jours !

Les GAFAs, en alerte rouge, se sont quant à eux lancés dans une course effrénée à l’IA, que Bing a déjà intégrée dans son expérience de recherche et que google s’apprête à intégrer à tous ses produits.

L’adoption est là.

Ainsi, ma conviction forte est que le vrai Web3 est le web conversationnel. Parler à son navigateur, c’est ça le futur. Demander à Spotify de nous mettre une chanson qui correspond à notre humeur, poser une question libre à google, lui demander d’élaborer, de clarifier, se forger un avis comme on le ferait en discutant avec un spécialiste de n’importe quel domaine. Une vraie expérience de science-fiction.

Yann LeCun a tort. Même si la technologie n’est pas aussi révolutionnaire en théorie, elle l’est en pratique. L’IA va changer entièrement notre relation aux outils sur lesquels on passe déjà la plupart de nos journées.

Mais qui dit gain massif de productivité dit impact sur l’emploi.

L’IA va détruire des jobs

Dans un post récent, l’investisseur Marc Andreessen partageait le graphique ci-dessous dans un billet dénommé “Pourquoi l’IA ne va pas créer du chômage”.

L’idée qu’il défend, en substance, est la suivante : certains marchés sont régulés à l’excès par ce qu’il appelle des “cartels”, ce qui rend tout progrès de pointe impossible.

Nous allons droit vers un monde où payer 4 années d’études coûte $1m mais où l’on peut acquérir une télé qui couvre un mur pour $100

Aux USA, les prix de la santé, de l’éducation et des hôpitaux ne cessent d’augmenter tandis que ceux des produits physiques s’effondrent. Il se pourrait qu’une hyper régulation de la technologie préserve artificiellement la valeur de certains écosystèmes pendant une période, les protégeant du remplacement algorithmique de labeur humain.

Mais on n’est aujourd’hui qu’à l’émergence de la technologie.

La réalité, c’est que l'IA est déjà meilleure que la plupart d’entre nous à effectuer des tâches sur lesquelles nous ne sommes pas experts. J’estime grossièrement ce chiffre à 90%.

Autrement dit, l’IA est d’après-moi plus forte que 90% d’un échantillon lambda pour écrire un article, rédiger une poésie, raconter une blague, créer une image dans un style spécifique, dessiner, développer un site web basique, etc.

GPT-4, sorti cette semaine, a codé le jeu “pong” en 60 secondes, créé un site web entier à partir de la photo d’un croquis sur un coin de page, réussi les examens d’entrée à de nombreux concours mieux que 90% des candidats et a dorénavant 25 000 mots de mémoire. Ce dernier point est critique : il signifie que les objections sur l’absence de mémoire de l’IA sont en train de s’envoler.

Heureusement l’IA n’est pour l’instant pas meilleure que ceux dont c’est le métier - du moins, ceux qui ont eu quelques années pour développer leurs compétences.

C’est comme si nous étions tous capables de parler 1000 mots dans toutes les langues du monde. Nous pourrions voyager plus facilement, mais pas communiquer aussi bien qu’un natif.

Par exemple, ChatGPT permet à celui qui n’est pas à l’aise avec les mots de s’exprimer sur Linkedin, tout comme il permet à un parent de mettre des images sur l’histoire imaginée par son enfant. Aucune de ces deux tâches n’a un impact sur le chômage car aucun de ces deux personnages n’aurait payé quelqu’un d’autre pour faire cette tâche.

C’est un bonus.

D’autant plus que de nouveaux métiers émergent : le plus médiatisé est sans doute celui de “prompt engineer”. Ses défenseurs soutiennent que savoir “parler à la machine” de la bonne manière est un métier du futur, tandis que ses détracteurs pensent que les interfaces seront suffisamment intuitives pour s’affranchir de cette compétence.

Un métier qui émerge… pour des milliers qui pourraient être sérieusement secoués dans les années à venir.

Car la technologie progresse tous les jours. Il est quasiment inévitable que d’ici 5 à 10 ans, ce ne soit plus 90% mais peut être 95 ou 99% de la population qui sera battue par l’IA. Dans ce scénario, même ceux dont c’est la profession seront directement touchés.

Que faire alors, quand la plupart des professionnels sont dépassés par la technologie ? Quand une seule personne équipée de ChatGPT peut remplacer une équipe entière ? Ça a déjà commencé.

Une opposition de masse ? Si l’IA peut déjà aider à mieux détecter les cancers que nos meilleurs praticiens, quelle personnalité politique osera la bloquer quand ses promesses seront encore plus belles ?

Il ne reste que deux options à moyen terme : emprunter la voie que prédit Marc Andreessen, c’est à dire de maintenir artificiellement l’emploi obsolète de salariés désabusés, ou repenser entièrement notre paradigme, tant sur le sens de nos sociétés que sur la distribution des richesses et la gestion de notre temps.

Que se passerait-il si notre temps libre était soudainement décuplé ? Nous continuerions probablement une pente déjà entamée : l’immersion dans le digital.

La vraie dystopie, c’est pour bientôt

La transition du réel au virtuel a été entamée il y a quelques années, incarnée notamment par le fameux pivot de Zuckerberg vers Meta. Mais l'engouement tardait à venir.

Que ce soit sur l’internet traditionnel ou dans le Web 3, les chiffres n’étaient pas impressionnants. Contraint par l’obligation de posséder un casque à $700 pour y accéder, le métavers de Meta “Horizons World” compterait 300 000 utilisateurs actifs, soit 1/10 000e de ceux de facebook ! Au même moment, l’univers virtuel dominant du Web3, Decentraland, peinerait à dépasser les 1000 utilisateurs quotidiens alors que sa valorisation dépasse le milliard de dollars…

Outre l’aspect technique qui limite les métavers issus de la blockchain, le plus gros frein à l’adoption à grande échelle de ces univers était sans aucun doute leur aspect dépeuplé.

Pour y remédier, on pourrait vivifier artificiellement ces univers avec des personnages non joueurs pour répliquer le lien social dont on a besoin, celui-là même qui nous fait allumer la télévision quand on est seuls chez nous. Mais programmer des millions de personnages réalistes et interactifs est une tâche titanesque…

Sauf avec l’IA, bien sûr.

Soudainement, il est possible de générer des armées de PNJs cohérents qui vaquent à leur occupation. Bientôt, on sera probablement incapables de faire la différence entre un humain et la plupart des IAs.

Ceci est une aubaine pour les univers virtuels, qui permettront à une population qui n’a jamais été aussi seule de trouver plus facilement des compagnons et de tisser des liens virtuels.

Ce chemin n’est pas anodin : il pourrait mener aux pires dystopies. Le monde autour de nous correspond de moins en moins à celui pour lequel notre cerveau a évolué - si nous passons le plus clair de notre temps immergés dans un monde digital, il se pourrait que nous finissions par vouloir fusionner avec la machine.

Exporter sa conscience et la faire voyager à notre place aux confins de la galaxie pourrait être notre seule possibilité de survivre à la mort du soleil dans 5 milliards d’années, mais pose un certain nombre de questions que je réserve à un prochain article.

Une chose est sûre : les IAs sont là pour rester.

La mode va passer… mais l’usage restera

Dans le post twitter ci-dessous, je prédisais que le grand public s’apprêtait à arriver au sommet de l’engouement sur l’IA et que c’était une bonne chose.

J’ai en effet remarqué depuis janvier une certaine lassitude des IAs génératives par le grand public : chacun a testé, atteint les limites de l’aspect brut des premiers outils et s’en est détaché, en attente d’un usage plus concret.

Même si GPT-4 est en train de recréer un engouement, l’humain a tendance à s’habituer à tout, y compris aux révolutions.

Toute nouvelle technologie fait le buzz pendant une période et se calme ensuite, le temps de comprendre la manière dont elle va s’insérer dans nos quotidiens. Ça implique que les entrepreneurs doivent l’intégrer à des applications existantes où en créer de nouvelles.

Et c’est le cas, aujourd’hui des IAs. Construire ces produits prend du temps, mais dans quelques mois il y aura du ChatGPT (ou concurrent) dans tous nos logiciels, peut-être même sans que l’on s’en rende compte.

C’est pour cela que je me joins à l’aventure avec Argil. Si cette technologie est, comme je le pense, une révolution, je refuse de la regarder passer depuis la fenêtre.

Je veux en être.

Clique ici pour me suivre sur twitter et n’hésite pas à partager et à t’abonner 👇